Inteligencia Artificial (IA)

6 nov 2025

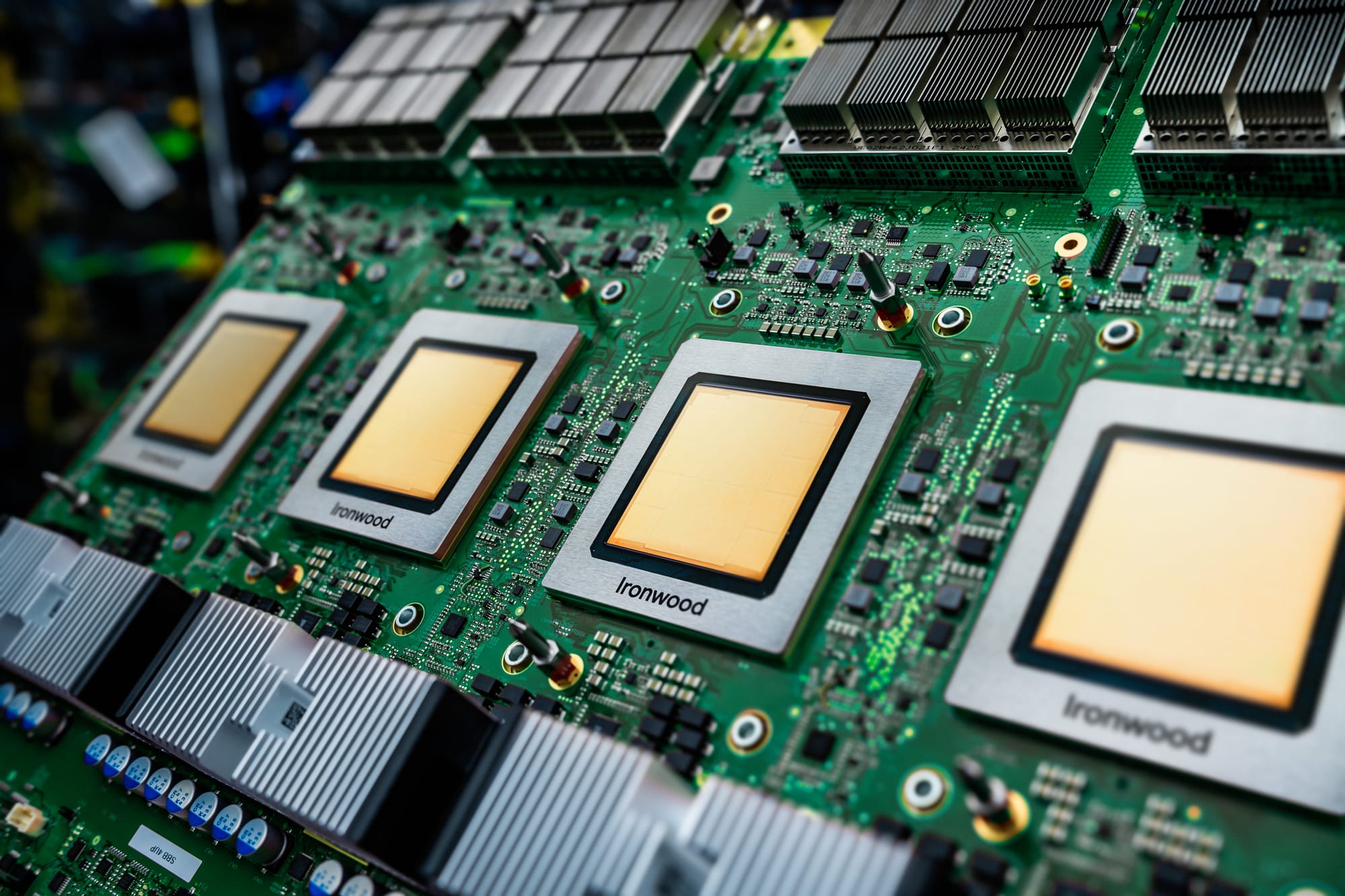

Google Cloud presenta Ironwood TPU y nuevas instancias Axion: innovación en computación en la nube

Descubre Ironwood, la séptima generación de TPU de Google Cloud, diseñada para entrenamiento de IA a gran escala, inferencia de alto volumen y baja latencia. Con hasta 10× más rendimiento que TPU v5p y nuevas instancias Axion optimizadas para precio-rendimiento, impulsa tu empresa, SaaS o laboratorio de IA con la infraestructura más avanzada y eficiente del mercado. Disponibilidad general próximamente.

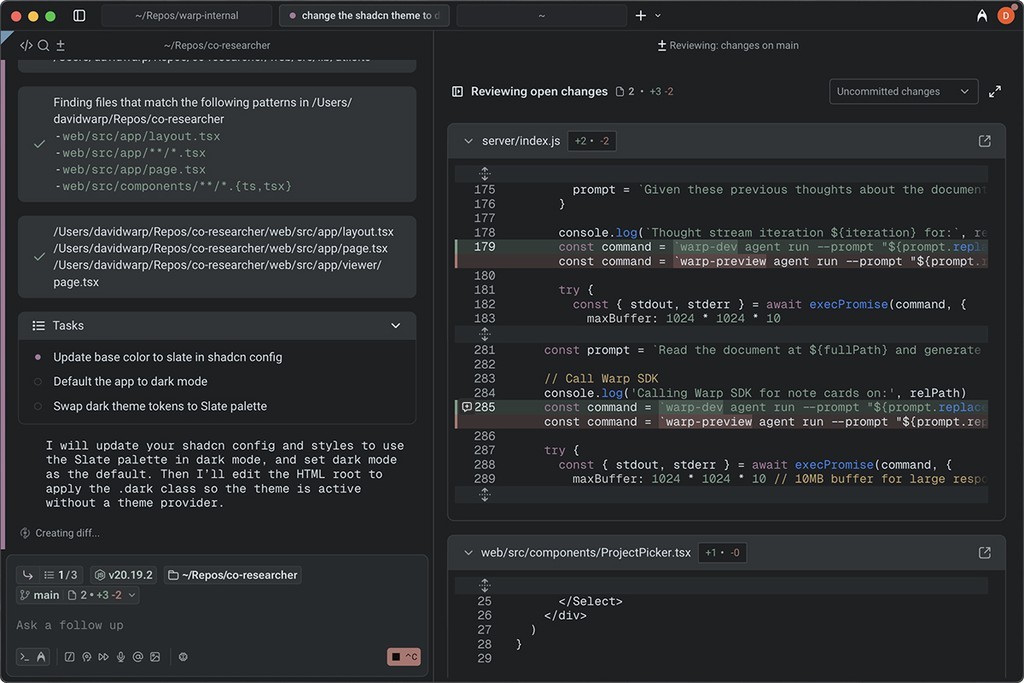

Google Cloud ha presentado Ironwood, su séptima generación de TPUs, junto con las nuevas instancias Axion, marcando un avance significativo en infraestructura para IA. Ironwood está diseñada para entrenamiento a gran escala, aprendizaje por refuerzo complejo y despliegue de modelos con alta demanda y baja latencia. Su disponibilidad general se espera en las próximas semanas.

Ironwood destaca por su rendimiento: ofrece un aumento de 10× en capacidad máxima frente a la TPU v5p y más de 4× por chip respecto a la v6e. Cada pod puede conectar hasta 9,216 chips mediante un Inter-Chip Interconnect de 9.6 Tb/s y compartir 1.77 PB de HBM. La tecnología Optical Circuit Switching permite redirigir el tráfico ante fallos, y los pods pueden escalarse en clústeres multipod. Según Google, Ironwood alcanza 118× más FP8 ExaFLOPS a nivel de pod que su competidor más cercano, lo que la posiciona como una opción líder para servir modelos de frontera.

La co-innovación de hardware y software es clave: MaxText introduce rutas SFT y GRPO; el soporte para vLLM facilita alternar entre GPUs y TPUs con mínimos cambios de configuración; y GKE Inference Gateway reduce el tiempo hasta el primer token hasta en un 96% y los costos de servicio hasta en un 30%.

Entre los primeros usuarios, Anthropic planea acceder a hasta un millón de TPUs; Lightricks reporta mejoras en la calidad de IA generativa; Vimeo experimentó un 30% más de rendimiento en transcodificación con Axion; ZoomInfo observó un 60% de mejora en precio-rendimiento; y Rise redujo su cómputo en un 20%.

En cuanto a Axion, la N4A (actualmente en vista previa) es una máquina virtual basada en Arm optimizada para precio-rendimiento, con hasta 64 vCPUs, 512 GB DDR5 y 50 Gbps de red. La C4A metal, próxima a lanzarse en vista previa, es una instancia bare-metal orientada a hipervisores, desarrollo nativo en Arm y grandes granjas de pruebas.

Este lanzamiento se apoya en más de una década de innovación en silicio personalizado por parte de Google, incluyendo TPUs, VCUs de YouTube y cinco generaciones de procesadores Tensor, todos desarrollados con co-diseño a nivel de sistema. Desde la primera TPU, lanzada hace ocho años, hasta la infraestructura actual con almacenamiento Titanium, refrigeración líquida avanzada y una disponibilidad del 99.999% desde 2020, Google refuerza su liderazgo en costo, escala y confiabilidad para la computación de IA.

Disponibilidad: Ironwood estará disponible en las próximas semanas; Axion N4A ya está en vista previa; C4A metal lo estará próximamente.